Von KIM BELLARD

Ich bin ein Fan von KI. Ich verstehe die technischen Aspekte nicht wirklich, aber ich bin von ihrem Potenzial begeistert. Außerdem bin ich ein Fan von eingängigen Phrasen. Als ich (verspätet) von TinyAI erfuhr, war ich sofort begeistert.

Wie sich herausstellt, gibt es TinyAI (auch bekannt als Tiny AI) schon seit einigen Jahren, aber mit dem allgemeinen Anstieg des Interesses an KI erhält es jetzt noch mehr Aufmerksamkeit. Es gibt auch TinyML und Edge AI, deren Unterschiede ich hier nicht näher erläutern werde. Der Punkt ist, dass KI keine riesigen Datensätze umfassen muss, die auf riesigen Servern irgendwo in der Cloud ausgeführt werden; sie kann auf jedem beliebigen kleinen Gerät erfolgen. Und das ist ziemlich aufregend.

Was mir auffiel, war ein Überblick in Cell von Farid Nakhle, einem Professor an der Temple University, Japan Campus: Shrinking the Giants: Paving the Way for TinyAI. „Der Übergang von der Landschaft großer Modelle künstlicher Intelligenz (KI) zum Bereich des Edge Computing, das seine Nische in taschengroßen Geräten findet, läutet eine bemerkenswerte Entwicklung der technologischen Möglichkeiten ein“, beginnt Professor Nakhle.

Die vielen Erfolge der KI, so glaubt er, „erfordern einen Sprung in ihren Fähigkeiten und einen Paradigmenwechsel in der Forschungslandschaft, von zentralisierten Cloud-Computing-Architekturen zu dezentralisierten und Edge-zentrierten Frameworks, bei denen Daten auf Edge-Geräten in der Nähe ihres Entstehungsortes verarbeitet werden können.“ Die Anforderungen an Echtzeitverarbeitung, reduzierte Latenz und verbesserte Privatsphäre machen TinyAI attraktiv.

Dementsprechend: „Dies erfordert TinyAI, hier definiert als die Komprimierung und Beschleunigung bestehender KI-Modelle oder den Entwurf neuartiger, kleiner, aber effektiver KI-Architekturen und die Entwicklung dedizierter KI-beschleunigender Hardware, um deren effiziente Bereitstellung und Betrieb auf Edge-Geräten nahtlos sicherzustellen.“

Professor Nakhle gibt einen Überblick über diese Komprimierungs- und Beschleunigungstechniken sowie über Architektur- und Hardwaredesigns. All dies überlasse ich dem interessierten Leser als Übung.

Wenn das alles futuristisch klingt, hier einige aktuelle Beispiele für TinyAI-Modelle:

Diesen Sommer brachte Google Gemma 2 2B auf den Markt, ein Modell mit 2 Milliarden Parametern, das angeblich GPT 3.5 von OpenAI und Mixtral 8X7B von Mistral AI übertrifft. VentureBeat meinte: „Der Erfolg von Gemma 2 2B deutet darauf hin, dass ausgefeilte Trainingstechniken, effiziente Architekturen und hochwertige Datensätze die rohe Parameteranzahl kompensieren können.“ Außerdem stellte OpenAI in diesem Sommer GPT-4o mini vor, „unser kosteneffizientestes kleines Modell“. Es „unterstützt Text und Vision in der API, und Unterstützung für Text-, Bild-, Video- und Audio-Ein- und -Ausgaben ist in der Zukunft geplant.“ Salesforce stellte vor Kurzem sein Modell xLAM-1B vor, das gerne als „Tiny Giant“ bezeichnet wird. Es hat angeblich nur 1 Milliarde Parameter, doch Marc Benoff behauptet, es sei modelx 7-mal so groß und verkündet kühn: „Die agentenbasierte KI auf dem Gerät ist da“. In diesem Frühjahr brachte Microsoft Phi-3 Mini auf den Markt, ein Modell mit 3,8 Milliarden Parametern, das klein genug für ein Smartphone ist. Es soll sich gut mit GPT 3.5 und Metas Llama 3 vergleichen lassen. H2O.ai bietet Danube 2, ein 1,8-B-Parametermodell, das Alan Simon von Hackernoon als das genaueste der winzigen Open-Source-LLM-Modelle bezeichnet.

Ein paar Milliarden Parameter klingen vielleicht nicht so „winzig“, aber bedenken Sie, dass andere KI-Modelle Billionen davon haben können.

TinyML hat sogar eine eigene Stiftung, „eine weltweite gemeinnützige Organisation, die eine Gemeinschaft von Fachleuten, Akademikern und politischen Entscheidungsträgern unterstützt, die sich auf energiesparende KI am Rand der Cloud konzentrieren.“ Der ECO Edge-Workshop im nächsten Monat wird sich auf die „Förderung nachhaltigen maschinellen Lernens am Rand“ konzentrieren.

Rajeshwari Ganesan, renommierter Technologe bei Infosys, behauptet in AI Business sogar: „Tiny AI ist die Zukunft der KI.“ Sie teilt tinyMLs Sorge um Nachhaltigkeit; die „mit KI verbundenen Umweltkosten sind besorgniserregend. KI hat bereits einen riesigen CO2-Fußabdruck – sogar größer als der der Luftfahrtindustrie.“ Angesichts der Milliarden – ja, richtig, Milliarden – von IoT-Geräten, die in den nächsten Jahren online gehen werden, warnt sie: „Der Bedarf an Rechenleistung könnte aufgrund der schieren Menge der von ihnen generierten Daten explodieren. Es ist zwingend erforderlich, einen Teil der Rechenlast auf Edge-Geräte zu verlagern. Solche kleinen KI-Modelle können auf Edge-IoT-Geräte übertragen werden, die nur minimalen Energie- und Rechenaufwand erfordern.“

Das europäische Technologieunternehmen Imec ist ein großer Befürworter von TinyAI und fürchtet ebenfalls die ökologischen Auswirkungen der KI. Es bezeichnet die derzeitigen Ansätze zur KI als „ökonomisch und ökologisch nicht tragfähig“. Stattdessen glaubt das Unternehmen: „Die Ära der Cloud-Dominanz geht zu Ende: Zukünftige KI-Umgebungen werden dezentralisiert sein. Edge- und Extreme-Edge-Geräte werden ihre eigene Verarbeitung durchführen. Sie werden eine minimale Datenmenge an einen zentralen Hub senden. Und sie werden gemeinsam arbeiten – und lernen.“

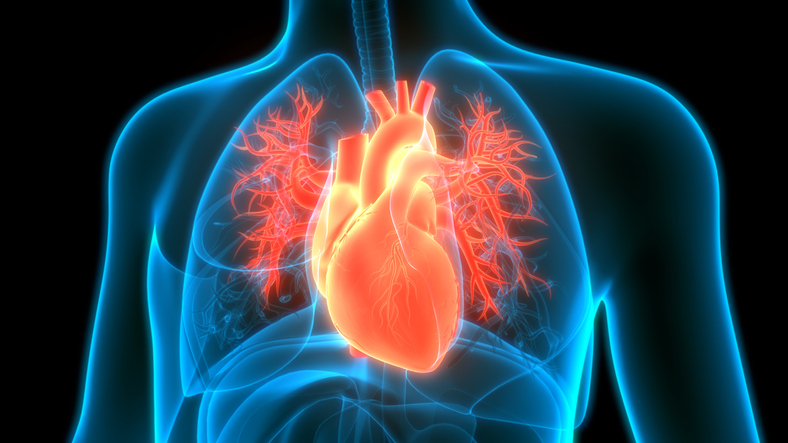

Der spannende Teil besteht natürlich darin, sich vorzustellen, wofür TinyAI eingesetzt werden könnte. Professor Nakhle sagt: „Unter den unmittelbaren und realistischen Anwendungen sticht das Gesundheitswesen als Bereich hervor, der reif für Veränderungen ist.“ Er beschreibt solche potenziellen Veränderungen weiter:

In Kombination mit erschwinglichen, auf bestimmte Regionen und Länder zugeschnittenen Preisen können tragbare Geräte mit TinyAI-Funktionen beispielsweise die Patientenüberwachung revolutionieren, indem sie Vitalfunktionen analysieren und Anomalien in Echtzeit erkennen und den Benutzer umgehend auf unregelmäßigen Herzrhythmus oder Blutdruckschwankungen aufmerksam machen. Auf diese Weise können rechtzeitige Eingriffe vorgenommen und die Gesundheitsergebnisse verbessert werden.

Imec sieht das Gesundheitswesen als einen besonderen Schwerpunktbereich und bietet diese Beispiele für TinyAI:

Ein weiteres Beispiel ist eine meiner Lieblingstechnologien für die Gesundheitsversorgung: Nanoroboter. Das MIT hat gerade eine winzige Batterie für den Einsatz in zellgroßen Robotern angekündigt, die „den Einsatz zellgroßer, autonomer Roboter zur Verabreichung von Medikamenten im menschlichen Körper ermöglichen könnte“, unter anderem. Jetzt müssen wir nur noch TinyAI in diese Roboter einbauen, damit sie die vielen Aufgaben erfüllen können, die wir ihnen stellen werden.

Wir haben bereits viele tolle Ideen für den Einsatz von KI im Gesundheitswesen; wir haben ihr Potenzial jedoch noch nicht einmal ausgeschöpft. Wenn wir uns erst einmal mit TinyAI beschäftigt haben, werden wir noch mehr Anwendungsmöglichkeiten finden. Die Zukunft ist riesig … und vielleicht winzig.

Wirklich aufregende Zeiten.

Kim ist eine ehemalige E-Marketing-Managerin bei einem großen Blues-Plan, Redakteurin des verstorbenen und betrauerten Tincture.io und jetzt regelmäßige THCB-Mitarbeiterin